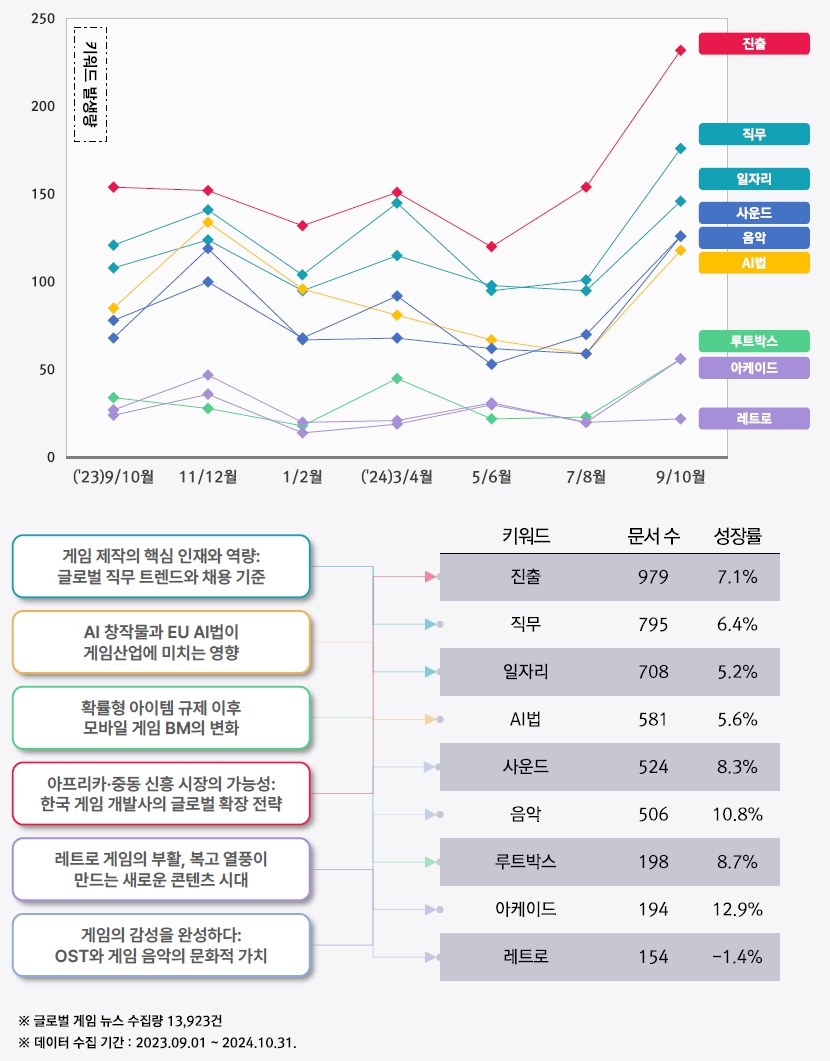

[정책] AI 창작물과 EU AI법이 게임산업에 미치는 영향

글로벌 게임산업 동향

1EU AI법과 국가별 AI 법률 현황

EU AI법 살펴보기

챗GPT와 같은 생성형 AI를 필두로 다양한 산업에서 AI 기술을 채택하고 있다. 이와 함께 AI 활용 사례가 늘어나면서 관련 법률 정비의 필요성이 제기되었다. EU는 AI 기술로 인한 분쟁과 사회적 문제를 해결하기 위해 2024년 8월 1일 세계 최초로 AI법(AI Act)을 공포하고 시행했다. AI법은 AI 기술을 위험 수준에 따라 분류하고, 각 단계에 적합한 규제와 준수 사항을 요구한다.

EU AI법은 AI 모델과 AI 시스템을 명확히 구분한다. AI 모델은 AI 작동에 사용되는 알고리즘과 논리 체계를 의미하며, AI 시스템은 AI 모델을 포함해 사용자 인터페이스나 입출력 장치 등 AI 기술 활용 과정의 모든 체계를 포괄한다.

EU는 AI 시스템을 위험 수준에 따라 네 단계로 분류한다: ‘수용 불가능한 위험(Unacce-ptable Risk)’, ‘고위험(High Risk)’, ‘제한적 위험(Limited Risk)’, ‘낮은 위험(Minimal Risk)’. 이러한 분류는 AI 알고리즘뿐만 아니라, AI가 실생활에서 사용되고 결과가 전달되는 모든 과정을 규제 대상으로 삼고 있다.

‘수용 불가능한 위험’으로 분류되는 AI 시스템은 생체 정보를 활용한 인종 구분, 사회적 지위 점수화, 아동 및 청소년의 발달과 행동에 영향을 미칠 수 있는 인지적 정보 제공 등을 포함하며 사용이 전면 금지된다. 이 외 단계는 AI 시스템의 사용 목적에 따라 제한 수준이 다르게 적용된다. 또한, EU AI법은 AI 시스템 개발자(Providers), 배포자(Deployers), 유통사(Distributors), 수입자(Importers)로 주체를 구분하고 각 주체가 EU 내에서 AI 시스템을 사용하는 경우 국적과 관계없이 법안 준수를 요구한다.

게임산업에 적용 가능한 EU AI법 규정

게임산업에서도 AI 도입이 확대되고 있다. 게임 기획, 디자인, 아트, 프로그래밍 등 다양한 개발 영역에서 AI가 활용되면서, 게임업계 역시 EU AI법의 영향을 받을 수밖에 없다. EU AI법에 따르면, 게임산업에서 AI 시스템은 주로 낮은 위험 수준으로 분류된다. 이에 따라 게임업계가 당장 법령 준수를 위해 대규모 자원을 투입할 필요는 적어 보인다.

그러나 AI 시스템이 아동 정서 발달이나 인식 형성에 영향을 미치는 콘텐츠 제작에 활용된다면, EU가 보호하려는 ‘취약 계층(vulnerable groups)’에 영향을 줄 수 있어 강한 규제를 받을 가능성이 있다. 예컨대, AI를 통해 제작된 게임 내 콘텐츠가 아동의 정서 발달에 부정적인 영향을 미친다면 개발자, 배포자, 유통사, 수입자 모두 제재 대상이 될 수 있다.

현재 게임업계가 EU AI법에서 가장 주목해야 할 부분은 게임 중독 방지와 관련된 사항이다. AI법은 AI 시스템이 사용자에게 해악을 끼치지 않도록 요구하며, 게임 제작사는 AI 기반 콘텐츠가 반복적인 플레이나 정신적·물질적 중독을 유발하지 않도록 주의해야 한다. 또한, 투명성 준수 조항에 따라 AI 기능이 게이머와 투명한 상호 작용을 할 수 있도록 시스템을 구축해야 한다.

결론적으로, EU AI법은 AI 시스템 개발자부터 유통사에 이르기까지 모든 주체가 책임 있게 AI를 개발하고 전달하도록 요구한다. 게임업계는 법안의 취지를 이해하고, AI 기술이 사용자에게 중대한 해악을 끼치지 않도록 주의를 기울여야 한다.

미국, 일본, 중국의 AI 관련 법률 및 규제 현황

EU 외에 AI 활용이 확대될 주요 거대 시장으로는 미국, 일본, 중국이 꼽힌다. 따라서 이들 3개국에서 AI 관련 법안이 어떻게 정비되고 있는지 확인해 볼 필요가 있다.

① 미국

연방 국가인 미국은 현재 연방 차원에서 AI 기술에 대한 세부 정의나 규제를 담은 법안은 존재하지 않는다. 그러나 각 주(State) 정부와 의회는 AI로 인한 문제를 규제하기 위한 다양한 법안을 제시하고 있다. 현재 미국의 AI 관련 법은 주로 개인 프라이버시 보호, 보안, 차별 금지(공정성 원칙)에 초점이 맞춰져 있다.

연방기구인 미 연방거래위원회(FTC, Federal Trade Commission)는 기존 소비자 보호 및 차별 금지 관련 법률을 통해 AI를 간접적으로 규제하는 방향에 관심을 두고 있다. 결론적으로, 미국은 AI를 직접적으로 다루는 연방 법안은 없으나, 기존 법안을 활용해 AI를 간접적으로 규제하고 있다.

② 일본

일본은 AI 산업을 강제적으로 규제하기보다는 자발적 준수를 권장하는 가이드라인을 활용하는 독특한 접근 방식을 취하고 있다. 미국과 마찬가지로 AI를 직접적으로 다루는 규제 법안은 존재하지 않으며, 일본 정부는 산업 혁신을 저해하지 않으면서도 잠재적 위험을 줄이기 위한 권고 기준을 제시하고 있다. 일본 정부는 AI가 인간 존엄성과 시민 안전을 해치지 않도록 하는 데 가장 큰 관심을 보이고 있으며, 위험 수준에 기반한 거버넌스 시스템을 지지하고 있다.

③ 중국

중국은 추천 알고리즘 및 생성형 AI 시스템에 관한 규제를 포함한 다수의 구속력 있는 AI 관련 규정을 도입했다. 이러한 규정은 투명성과 기술 활용의 윤리성을 보장하는 데 초점을 맞추고 있으며, 특히 AI 개발자의 책임을 강조하고 있다. 중국은 알고리즘 구성까지 규제하며, 가까운 시일 내 국가 차원에서 포괄적인 AI 법안을 도입할 가능성이 높다.

2게임산업 내 AI 창작물 도입과 대형·중소 개발사의 대응 전략

국가별 AI법이 게임산업에 미친 영향은?

① EU

EU는 개인의 건강, 안전, 환경, 기본적 인권 등 다양한 영역에서 AI 기술이 개인과 사회에 위협이 되지 않도록 포괄적 규제 프레임워크인 AI법을 도입했다. 게임업계는 AI 기술을 활용할 때 엔터테인먼트적 요소 외에도 인문학적, 윤리적 요인을 폭넓게 고려해야 한다. 특히 개인의 기본적 권리를 침해할 수 있는 AI 시스템 기능은 고위험 제재 대상이 될 수 있음을 유념해야 한다. EU는 또한 게이머를 부당하게 조작하거나 조작적인 메커니즘을 사용하는 기능을 규제하고 있어, 이러한 조항이 향후 게임 내 설계에 영향을 미칠 가능성이 있다.

② 미국

미국은 연방 차원의 포괄적 AI 규제가 없으나, 일부 주(State)가 관련 법률을 제정하며 AI 기술을 간접적으로 규제하고 있다. 특히 캘리포니아주의 캘리포니아 소비자 보호법(이하 CCPA)은 게임 회사가 사용자 데이터를 처리할 때 높은 수준의 프라이버시 보호를 요구하며, AI 기술이 데이터를 수집하고 사용하는 방식도 규제 대상에 포함한다. 이외에도 미국 내 여러 주가 프라이버시 강화와 차별 방지를 위한 AI 규제를 확대하고 있어, 이러한 움직임은 게임업계의 AI 시스템 개발에 큰 변수가 될 수 있다.

③ 일본

일본은 자발적 준수를 권장하는 가이드라인에 의존하며, AI 사용의 윤리적 측면을 강조하고 있다. 일본 정부는 AI를 규제하는 법안을 섣불리 도입할 경우 산업 성장을 저해할 수 있다고 판단하고, 권고 기준을 통해 위험을 관리하고 있다. 게임업계는 이러한 방향성에 맞춰 윤리적 기준을 준수하며 AI 기술 활용 범위를 확장할 수 있을 것으로 보인다.

대형 게임 개발사의 AI 모니터링 및 준수 전략 사례

① 소니 인터랙티브 엔터테인먼트(Sony Interactive Entertainment)

소니 인터랙티브 엔터테인먼트(이하 SIE)는 AI 기술이 게이머에게 미치는 잠재적 영향을 검토하고, 윤리적 기준을 준수하도록 내부 프레임워크를 운영하고 있다. SIE는 AI 기술이 개인에게 편향성과 왜곡된 인식을 제공하지 않도록 분석하고, 윤리적 정보를 수집 및 처리하는 프로세스를 구축했다. SIE의 AI 윤리 검토 프로젝트는 편향성 없는 공정성과 윤리적 책임성을 보장하는 데 초점을 맞추고 있다.

② 유비소프트(Ubisoft)

유비소프트는 ‘책임감 있는 AI(Responsible AI)’ 프로그램을 통해 AI 기술 개발과 배포 과정의 투명성과 추적 가능성을 보장하고 있다. 해당 프로그램은 내부 감사, AI 위험 평가, 영향 분석을 포함하며, AI 기술이 인간 존엄성을 훼손하지 않도록 관리한다. 이러한 노력은 AI 기술 활용에서 윤리적 기준을 준수하려는 기업의 의지를 보여준다.

③ 그 외

블리자드 엔터테인먼트(Blizzard Entertainment)와 일렉트로닉 아츠(EA)는 EU의 일반정보보호규정(GDPR)과 CCPA 준수를 위해 강력한 내부 통제 조치를 시행하고 있다. 이들은 개인 정보를 수집할 경우, 어떤 데이터를 어떻게 사용하는지 명확히 공지하고 동의를 받으며, 프라이버시 보호를 위해 최소한의 데이터만 수집하도록 원칙을 세웠다. 이러한 노력은 개인정보 관련 리스크를 줄이는 동시에 강화될 법률에 대비하는 기반이 되고 있다.

3한국 게임업계를 위한 AI 창작물 가이드라인과 대응 방안

AI 창작물의 저작권 및 책임 기준

국내 게임 개발사는 해외의 AI 관련법 동향을 지속적으로 점검해야 하지만, 무엇보다 국내법을 충분히 숙지해야 한다. 다음은 게임업계가 AI 기술을 활용해 창작물을 제작할 때 고려해야 할 주요 요소들이다.

① 저작권 기준

현재 국내법상 AI가 단독으로 생성한 콘텐츠는 저작권 보호 대상이 아니다. 이는 국내 저작권법이 인간의 사상과 감정을 표현한 창작물에만 저작권을 부여하기 때문이다. 따라서 AI 창작물과 인간이 개입한 창작물을 명확히 구분하는 기준이 필요하다. 또한, AI로 생성된 콘텐츠에 사람이 수정하거나 편집한 경우 이를 ‘편집저작물’로 간주해 제한적 저작권을 보호하는 지침을 마련할 필요가 있다.

② 책임 기준

AI를 활용하는 기업은 AI가 생성한 콘텐츠에 대한 책임을 져야 한다. 게임업계에서는 AI 기반 게임 콘텐츠가 게이머의 행동에 미치는 영향을 예측·평가할 수 있는 업무 프로세스를 마련해야 한다. 또한, 소비자에게 고위험 AI 콘텐츠를 사전에 경고하고, 사용자가 AI와의 상호작용을 직접 제어할 수 있는 옵트인(Opt-in) 방식의 시스템을 제공해야 한다.

③ 워터마크 및 공개

AI 생성 콘텐츠에 워터마크를 사용하면 콘텐츠 오남용을 방지하고 출처를 명확히 관리할 수 있다. 이를 위해 워터마크 표준을 설정하고, AI 생성 콘텐츠의 투명성과 저작권 강화를 위한 노력을 병행해야 한다. 예로, 구글은 2024년 10월에 AI 생성 콘텐츠를 식별할 수 있는 디지털 워터마크 솔루션인 ‘신스아이디(SynthID)’를 공개하기도 했다.

구글의 ‘신스아이디’를 통해 생성된 AI 워터마크 예시 출처 : Google DeepMind④ 일관된 검토 및 업데이트

AI 기술이 계속 발전하면서 AI 생성 콘텐츠와 관련된 소유권 논란이 더욱 심화될 가능성이 크다. 따라서 게임업계는 AI 창작물 관리 기준을 정기적으로 평가하고 업데이트해야 한다. 또한, 가이드라인 변경 시 이해 관계자가 참여할 수 있는 프로세스를 수립해 합의와 공감대를 형성해야 할 것이다.

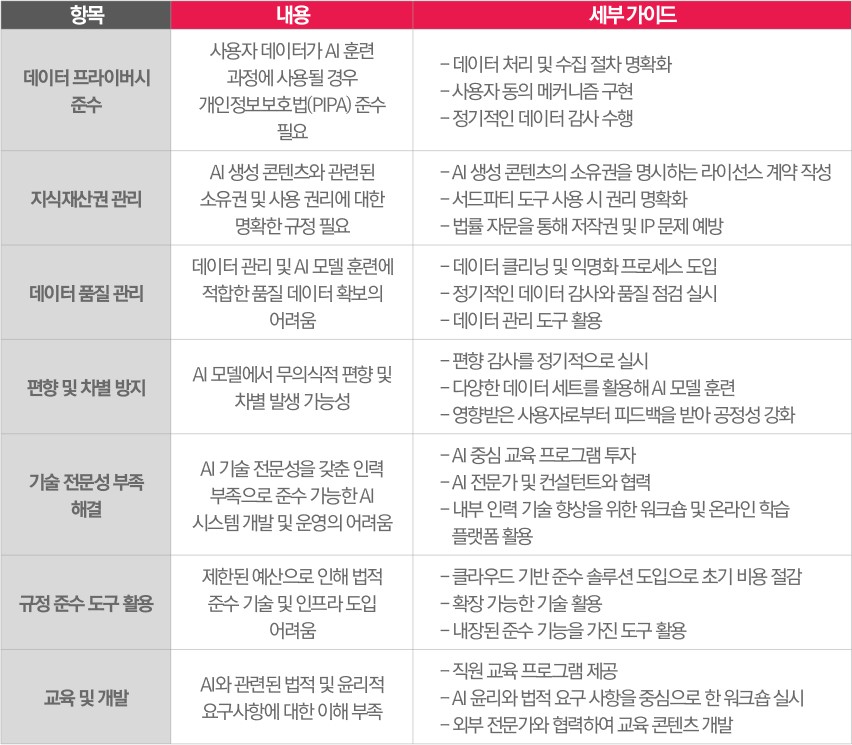

국내 게임 개발사들이 참고할 수 있는 대응 방안 및 법적 가이드

국내 게임 개발사는 AI 생성 창작물의 저작권 보호와 책임 기준을 명확히 하기 위해 여러 대응 방안을 참고할 수 있다. 우선, 데이터 프라이버시 준수를 위해 개인정보보호법을 기반으로 데이터 처리 기준을 수립하고, 정기적인 감사 프로세스를 운영해야 한다. 지식재산권 관리 측면에서는 AI 생성 콘텐츠의 권리를 명확히 규정하는 라이선스 계약을 체결하고, AI 훈련 알고리즘의 원작자에게 보상을 제공함으로써 분쟁을 예방할 수 있다.

데이터 품질 관리를 위해서는 데이터 클리닝과 익명화 프로세스를 도입해 개인 정보 유출 위험을 최소화하고, AI 모델의 편향성과 차별 문제를 정기적으로 점검해야 한다. 또한, AI 콘텐츠를 효율적으로 관리하기 위한 툴을 도입할 수 있으며, 초기 비용 부담이 클 경우 클라우드 기반 솔루션을 활용하는 방안도 고려해볼 만하다. 마지막으로, AI 생성 콘텐츠를 전문적으로 관리하기 위해 관련 인재를 육성해야 한다. 이를 위해 직원 교육 프로그램을 도입하거나 정기적인 워크숍을 진행하며, 외부 전문가를 활용하는 등의 방법으로 AI 창작물 관리 역량을 강화할 필요가 있다.

한국 게임 개발사를 위한 법적 실무 가이드- Carnegie Endowment.org. (2023. 07. 10). China’s AI Regulations and How They Get Made.

- Dentons. (2022. 04. 11). Copyright and AI – the Korean View.

- Dig Watch. (2024. 05. 21). South Korea announces plan for AI copyright and deepfake management.

- DLA Piper. (2024. 10. 28). Understanding AI Regulations in Japan.

- European Commission. (2024. 11. 30). AI Act.

- European Commission. (2024. 11. 30). AI Pact.

- European Parliament. (2023. 06. 18). EU AI Act: first regulation on artificial intelligence.

- Ground Labs. (2023. 08. 11). South Korea's guidance for the safe use of personal information in AI.

- Morris Manning & Martin. (2024. 10. 18). Legal Issues Around AI Are Real. And Complex.

- Norton Rose Fulbright. (2024. 04). Gaming and law: What businesses need to know/Part 4: Gaming and artificial intelligence.

- Pillsbury. (2024. 07. 19). The EU’s AI Act: A Review of the World’s First Comprehensive Law on Artificial Intelligence and What This Means for EU and Non-EU Companies.

- Pocket Gamer.biz. (2024. 08. 19). The EU’s AI Act: What does it mean for game developers?

- Product Marketing Alliance. (2024. 09. 25). Navigating GDPR, CCPA, and other regulations while leveraging user data for growth.

- Profile Tree. (2024. 05. 06). AI Laws in SME Operations and Compliance Strategies.

- Secure Privacy. (2023. 10. 04). Artificial Intelligence and Personal Data Protection: Complying with the GDPR and CCPA While Using AI.

- Sony. (2024. 11. 30). AI Ethics.

- Sony. (2024. 11. 30). Sony Group's Initiatives for Responsible AI.

- The Korea Times. (2024. 07. 23). Growing AI music production puts artist ethics, copyright law under scrutiny.

- The Korea Times. (2024. 10. 03). South Korea's AI dilemma: balancing innovation with ethical oversight.

- Ubisoft. (2024. 11. 30). Ubisoft, Mila And McGill Join Forces To Create New Research Chair On Responsible AI In Video Games.

- White & Case. (2024. 05. 13). AI Watch: Global regulatory tracker - United States.